1.1 ¿Por qué?

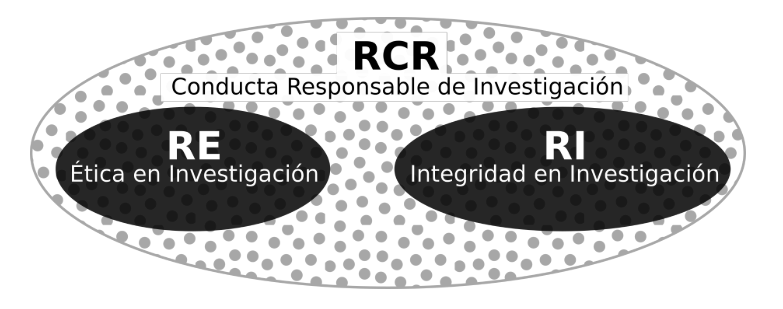

La pregunta del por qué es necesario avanzar hacia la transparencia encuentra su respuesta en la existencia de prácticas de investigación que merman la credibilidad de los hallazgos científicos. A modo de entender qué es lo problemático de ciertas prácticas, es que Steneck (2006) proponen el concepto de Conducta Responsable de Investigación (RCR, por sus siglas en inglés) cómo un ideal que engloba prácticas éticas e integras dentro de la investigación científica (ver Figura N° 1.2). Según los autores, la distinción entre la ética y la integridad recae en que la primera tiene que ver con seguir principios morales dentro de la investigación (e.g. usar consentimientos informados), en cambio, la segunda está más relacionada el seguimiento de códigos de conductas y estándares profesionales (Abril Ruiz 2019).

Figura 1.2: Conducta Responsable de Investigación. Imagen de Abril Ruiz (2019) basada en Steneck (2006)

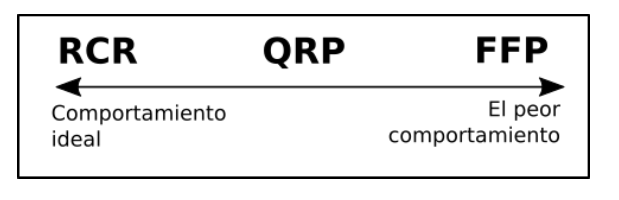

Las prácticas de investigación se pueden evaluar en un continuo que representa cuánto adhieren los investigadores a los principios de integridad científica (Steneck 2006). La Figura N° 1.3 esquematiza esta idea mostrando dos extremos, donde a la izquierda está el mejor comportamiento (RCR), y a la derecha el peor comportamiento (FFP). Las FPP son una abreviación en lengua inglesa para referirse a Fabrication, Falsification, Plagiarism (Invención, Falsificación y Plagio), también conocidas como mala conducta académica. En el medio del continuo están las prácticas cuestionables de investigación (QRP, por sus siglas en inglés) las cuáles refieren a “acciones que violan los valores tradicionales de la empresa de investigación y que pueden ser perjudiciales para el proceso de investigación” (National Academies of Science 1992 en Steneck 2006, 58). Las QRP se caracterizan porque tienen el potencial de dañar la ciencia, en tanto las FFP la dañan directamente.

Figura 1.3: Gradación del comportamiento integro en investigación. Imagen de Abril Ruiz (2019) basada en Steneck (2006)

La mala conducta académica implica la violación de los principios de integridad científica. Esto implica el falseamiento de datos de cualquier forma: invención de datos, alteración de gráficos o tablas, etc. El caso de Diderik Stapel presentado en la introducción de este capítulo es un ejemplo que cabe dentro del concepto de mala conducta académica. Según la literatura, la prevalencia de este tipo de prácticas no es alta (e.g. Fanelli 2009; John, Loewenstein, y Prelec 2012), sino que más bien son casos aislados (ver Abril Ruiz 2019, 23-128 para una revisión). En contraste, como veremos a continuación, las QRP han demostrado ser más prevalentes.

1.1.1 Prácticas cuestionables de investigación (QRP)

Existen una serie de estudios que han intentado medir directamente la prevalencia de estas prácticas a través de encuestas. Fanelli (2009) hizo un metaanálisis que tenía por objetivo sistematizar los resultados de estudios que hasta esa fecha habían abordado las prácticas de investigación desde encuestas cuantitativas. Los resultados mostraron que un 1.97% de investigadores había inventado datos al menos una vez (FFP) y que un 33.7% había realizado alguna vez una QRP como “borrar puntos de los datos basados en un sentimiento visceral”. Unos años más tarde, John, Loewenstein, y Prelec (2012) efectuaron otro estudio similar, demostrando que un 36.6% de quienes participaron alguna vez habían practicado alguna QRP. En detalle, analizando los porcentajes práctica a práctica se halló que el 50% de los psicólogos encuestados alguna vez reportaron selectivamente estudios que apoyaran su hipótesis; un 35% alguna vez reportaron resultados inesperados como esperados; y un 2% alguna vez reportó datos falsos. Este estudio ha sido replicado en Italia (Agnoli et al. 2017), en Alemania (Fiedler y Schwarz 2016) y en Brasil (Rabelo et al. 2020), con resultados similares.

Más recientemente, han emergido estudios similares en otras áreas disciplinarias. Por ejemplo, a través de encuestas online Makel et al. (2021) logran constatar que existe una prevalencia considerable de las QRP en el campo de investigación educacional. De los participantes de la muestra un 10% admitió haber rellenado datos faltantes (NA’s) y un 67% señaló alguna vez haber omitido ciertos análisis de manera intencional. Siguiendo el mismo método, en el campo de la investigación comunicacional se ha encontrado evidencia parecida: 9% de los encuestados señala haber imputado datos faltantes sin reportarlo, un 34% declaró alguna vez haber excluido casos extremos de forma arbitraria y un 60% señala no haber reportado análisis con variables clave que no funcionaron (Bakker et al. 2020). Del mismo modo, en los estudios cuantitativos sobre criminología existe un uso extendido de las QRP: un 87% de la muestra de Chin et al. (2021) ha utilizado múltiples QRP, siendo el reporte selectivo de resultados el más común (53%). Por último, fuera del área de las ciencias sociales, pero siguiendo la misma línea, Fraser et al. (2018) también hallan evidencia a favor de la existencia de distintas QRP en el campo de la ecología y evolución.

Los estudios mencionados arriba corresponden a la evidencia existente sobre la medición de QRP a través de encuestas. A modo de resumen, la Tabla N° 1.1 adaptada del trabajo de Chin et al. (2021) agrupa la información que hemos revisado (y más), ordenándose por prácticas, campos de estudio y los artículos correspondientes a cada campo de estudio. Los números dentro de las casillas representan el porcentaje de prevalencia de cada práctica reportado por los participantes del estudio, y entre paréntesis el número de casos de la muestra. Los guiones significan que este estudio no incluyó esa práctica en el cuestionario.

| Práctica | Psicología | Psicología | Psicología | Ecología | Evolución | Educación | Comunicación |

|---|---|---|---|---|---|---|---|

| John, Loewenstein, y Prelec (2012) | Agnoli et al. (2017) | Rabelo et al. (2020) | Fraser et al. (2018) | Fraser et al. (2018) | Makel et al. (2021) | Bakker et al. (2020) | |

| Omitir estudios o variables ni significativas | 46 (485) | 40 (217) | 55 (232) | - | - | 62 (783) | 60 |

| Subreportar resultados | 63 (486) | 48 (219) | 22 (232) | 64 | 64 | 67 (871) | 64 |

| Subreportar condiciones | 28 (484) | 16 (219) | 35 (232) | - | - | - | - |

| Muestreo selectivo | 56 (490) | 53 (221) | 22 (232) | 37 | 51 | 29 (806) | 23 |

| Excluir datos selectivamente | 38 (484) | 40 (219) | 20 (232) | 24 | 24 | 25 (806) | 34 |

| Excluir covariables selectivamente | - | - | - | - | - | 42 (773) | 46 |

| Cambiar análisis selectivamente | - | - | - | - | - | 50 (811) | 45 |

| HARK | 27 (489) | 37 (219) | 9 (232) | 49 | 54 | 46 (880) | 46 |

| Redondear valores p | 22 (499) | 22 (221) | 18 (232) | 27 | 18 | 29 (806) | 24 |

| Mal orientar respecto a los efectos de sociodemográficos | 3 (499) | 3 (223) | 4 (232) | - | - | - | - |

| Esconder problemas | - | - | - | - | - | 24 (889) | - |

| Esconder imputaciones | 1 (495) | 2 (220) | 1 (232) | 5 | 2 | 10 (898) | 9 |

Cómo se puede ver en la Tabla N° 1.1, las encuestas sobre QRP han incluido varias prácticas relativas al tratamiento y análisis de los datos. No obstante, consideramos que exiten tres términos que, en su mayoría, logran sintetizar esta tabla y que están relacionados a la transparencia en los diseños de investigación. Estas son: 1) los sesgos de publicación, 2) el p-hacking y el 3) HARKing.

Sesgo de publicación

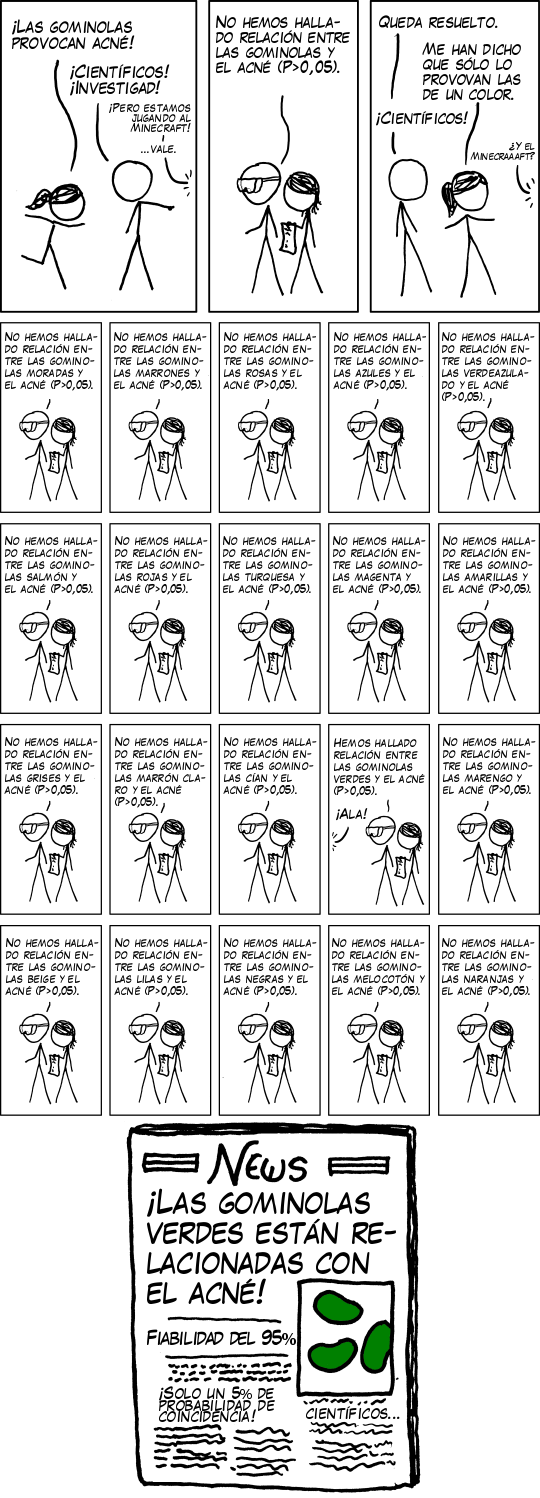

El sesgo de publicación ocurre cuando el criterio determinante para que un artículo sea publicado es que sus resultados sean significativos, en desmedro de la publicación de resultados no significativos. Un ejemplo ilustrativo que usan G. S. Christensen, Freese, y Miguel (2019) para explicar esta práctica es el cómic xkcd títulado Significant. En el comic (Figura N 1.4) se puede observar que un personaje corre gritando que las gominolas (jellybeans) causan acné, a lo que el otro personaje llama a los científicos para que prueben esta hipótesis, resultando no significativa. Ante esto, nuevamente el personaje inicial plantea que podría depender del tipo de gominola, y es aquí donde se aprecia lo ilustrativo del cómic: aparecen 20 paneles, cada uno representando una prueba de hipótesis entre una gominola de determinado color y al acné. 19 de las pruebas resultan no significativas, y una (el color verde) resulta significativa. El cómic termina con una portada con el titular de la única prueba de hipótesis que arrojó resultados significativos.

Figura 1.4: Comic Significant de xkcd

El cómic anterior muestra cómo es que un hallazgo de investigación sufre del sesgo de publicación. Al publicarse únicamente el resultado significativo e ignorándose los otros 19 no significativos, cualquier lector tendería a pensar que efectivamente las gominolas verdes causan acné, cuando probablemente sea una coincidencia. Rosenthal (1979) fue de los primeros trabajos en llamar la atención respecto de esta práctica, adjudicando el concepto de file drawer problem (en español: problema del cajón de archivos), el que hace alusión a los resultados que se pierden o quedan “archivados” dentro de un cuerpo de literatura. Desde ese estudio en adelante varios autores han contribuido con evidencia empírica sobre el sesgo de publicación. Por ejemplo, el estudio de Franco, Malhotra, y Simonovits (2014) logra cuantificar esta situación encontrando que los resultados nulos tienen un 40% menos de probabilidades de ser publicados en revistas científicas, en comparación a estudios con resultados significativos. Es más, muchas veces los resultados nulos ni siquiera llegan a ser escritos: más de un 60% de los experimentos que componen la muestra del estudio de Franco, Malhotra, y Simonovits (2014) nunca llegaron a ser escritos, en contraste al menos del 10% de resultados significativos.

El principal problema del sesgo de publicación es que puede impactar en la credibilidad de cuerpos enteros de literatura. Por ejemplo, en economía se han hecho varios metaanálisis que han buscado estimar el sesgo de publicación en distintos cuerpos de literatura (e.g. Brodeur et al. 2016; Vivalt 2015; Viscusi 2014). Uno de los trabajos más concluyentes es el de Doucouliagos y Stanley (2013), quienes efectúan un meta análisis de 87 artículos de meta análisis en economía. En este trabajo encuentran que más de la mitad de los cuerpos de literatura revisados sufren de un sesgo “sustancial” o “severo”. Sí bien en economía se ha avanzado mucho en este tipo de estudios, también a partir del desarrollo de distintos métodos de detección, se ha podido diagnosticar el sesgo de publicación en importantes revistas en sociología y ciencias políticas (A. S. Gerber y Malhotra 2008; A. Gerber y Malhotra 2008).

P-hacking

Otra práctica bastante cuestionada es el p-hacking. El p-hacking suele englobar muchas de las prácticas que vimos en un inicio, especialmente las que refieren al manejo de datos: excluir datos arbitrariamente, redondear un valor p, recolectar más datos posterior a hacer pruebas de hipótesis etc. Lo que tienen todas estas prácticas en común y lo que define el p-hacking es que se da cuando el procesamiento de los datos tiene por objetivo obtener resultados significativos. Si el sesgo de publicación afecta la credibilidad de un cuerpo de literatura, el p-hacking afecta a la credibilidad de los artículos mismos, ya que al forzar la significancia estadística la probabilidad de que en realidad estemos frente a un falso positivo aumenta. Un trabajo que da sustento a esta idea es el de Simmons, Nelson, y Simonsohn (2011), quienes calculan la probabilidad de obtener un falso positivo (error Tipo I) de acuerdo con el nivel de grados de libertad que son utilizados por parte de los investigadores. El resultado principal es que a medida que aumenta el uso de grados de libertad, la posibilidad de obtener un falso positivo aumenta progresivamente.

El p-hacking también contribuye a sesgar cuerpos enteros de literatura. Para diagnosticar esto se ha utilizado una herramienta denominada p-curve, la cual “describe la densidad de los p-values reportados en una literatura, aprovechando el hecho de que si la hipótesis nula no se rechaza (es decir, sin efecto), los p-values deben distribuirse uniformemente entre 0 y 1” (G. S. Christensen, Freese, y Miguel 2019, 67.). De esta manera, en cuerpos de literatura que no sufran de p-hacking, la distribución de valors p debería estar cargada a la izquierda (siendo precisos, asimétrica a la derecha), en cambio, si existe sesgo por p-hacking la distribución de p-values estaría cargada a la derecha (asimetría a la izquierda). Simonsohn, Nelson, y Simmons (2014) proponen esta herramienta y la prueban en dos muestras de artículos de la Journal of Personality and Social Psychology (JPSP). Las pruebas estadísticas consistieron en confirmar que la primera muestra de artículos (que presentaban signos de p-hacking) estaba sesgada, en cambio la segunda muestra (sin indicios de p-hacking), no lo estaba. Los resultados corroboraron las hipótesis, esto es: los artículos que presentaban solamente resultados con covariables resultaron tener una p-curve cargada a la derecha (asimétrica a la izquierda).

HARKing

Por último, pero no menos importante está la práctica del HARKing. El nombre es una nomenclatura en lengua inglesa para Hypothesizing After the Results are Known, que literalmente significa establecer las hipótesis del estudio una vez que se conocen los resultados (Kerr 1998). El principal problema de esta práctica es que confunde los dos tipos de razonamiento que están a la base de la ciencia: el exploratorio y el confirmatorio. El objetivo principal del razonamiento exploratorio es plantear hipótesis a partir del análisis de los datos, en cambio, el razonamiento confirmatorio busca plantear hipótesis basado en teoría y contrastar esas hipótesis con datos empíricos. Como señala Nosek et al. (2018), cuando se confunden ambos tipos de análisis y se hace pasar un razonamiento exploratorio como confirmatorio se está cometiendo un sesgo inherente, ya que se está generando un razonamiento circular: se plantean hipótesis a partir del comportamiento de los datos y se confirman las hipótesis con esos mismos datos.